Seit der Einführung von ChatGPT Ende 2022 sind wir alle von den Möglichkeiten der generativen KI und Large Language Models (LLMs) begeistert. Was die Leute faszinierte, war die unglaubliche Leichtigkeit, mit der qualitativ hochwertige Texte, Antworten auf Fragen, Codefragmente usw. generiert werden können. Alles, was man braucht, ist eine Eingabeaufforderung, d. h. eine Texteingabe, die man in die ChatGPT-API einspeist, und voilà, man erhält seine Antwort. Wir befinden uns immer noch in dem Hype um die generative KI, bei dem die Vorteile einer Technologie überbewertet werden. Für Unternehmen ist es wichtig, die Fallstricke zu vermeiden und zu verstehen, wann und wie sie ChatGPT oder generative KI-Lösungen einsetzen sollten. In diesem Blogbeitrag blicken wir über den Hype hinaus und zeigen einen Ansatz zur Evaluierung und Implementierung von LLM-basierten Gen-KI-Anwendungsfällen.

Wie kannst Du LLM-Anwendungsfälle bewerten und umsetzen?

Grundlegende LLMs sind sehr große, tiefe neuronale Netze, die mit Petabytes von Daten aus extrem großen Textsammlungen trainiert werden, um nützliche Sprachmuster zu lernen. Dieser breit angelegte Ansatz in Verbindung mit der Architektur eines neuronalen Transformer-Netzwerks ermöglicht den Einsatz von LLMs bei vielen sprachbezogenen Geschäftsaufgaben. Die Vielseitigkeit hat jedoch ihren Preis. Im Vergleich zu anderen, aufgabenspezifischeren KI-Lösungen besteht ein höheres Risiko für schlechte Qualität oder sachliche Fehler in den generierten Ergebnissen. Daher müssen wir in einem typischen geschäftlichen Anwendungsfall Kontrollen und Sicherheitsvorkehrungen um das LLM herum aufbauen.

Nehmen wir an, Du hast eine großartige Idee für einen LLM-Anwendungsfall und möchtest beurteilen, ob und wie dieser in Deinem Unternehmen eingesetzt werden könnte. Dabei hilft Dir folgender strukturierter Ansatz mit vier Schritten:

1. Geschäftswert und Risikobewertung Deines Anwendungsfalls

2. Entwurf von Prozessen für die Nutzung des LLMs und für die Abschwächung der Risiken

3. LLM-Lösungsansatz

4. LLM-Auswahl

1. Geschäftswert und Risikobewertung

Dein Ausgangspunkt ist der potenzielle Geschäftswert. Bewerte den potenziellen Nutzen des Anwendungsfalls, z. B. Kosteneinsparungen, Effizienzverbesserungen, Umsatzsteigerungen. LLMs werden in der Regel bei textintensiven Aufgaben eingesetzt, so dass das Textvolumen, die Häufigkeit der Aufgabe und die investierte Zeit der Mitarbeiter:innen gute Ausgangspunkte für die Bewertung sind. Prüfe sorgfältig die Risiken, die mit dem Einsatz eines LLMs verbunden sind, z. B. DSGVO und Verletzungen der Datensicherheit oder Konsequenzen fehlerhafter Antworten. Muss das LLM Deine internen Daten berücksichtigen und welche Risiken sind damit verbunden? Wie fehlertolerant ist Dein Anwendungsfall? Dies hat erhebliche Auswirkungen auf die Geschäftsprozesse, die Du um das LLM herum aufbauen musst. Wenn die Anforderungen an die Korrektheit und Faktizität der Aufgabe hoch sind, musst Du Sicherheitsvorkehrungen in den Prozess einbauen, der das LLM nutzt.

2. Entwurf von Prozessen für die Nutzung des LLMs und für die Abschwächung der Risiken

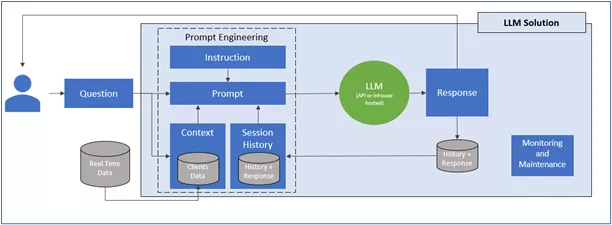

Als Nächstes kannst Du damit beginnen, die Prozesse rund um den Einsatz des LLMs zu entwerfen. Denke daran, dass das LLM nur ein kleiner Teil der Lösung ist. Der Rest liegt in der Pipeline, den Kontrollen und den Datenflüssen, die Du um das LLM herum aufbauen wirst. In welcher Situation soll das LLM verwendet werden und welche Informationsquellen stehen Dir zur Verfügung? Auf dieser Grundlage kannst Du einen schnellen technischen Ansatz und eine LLM-Pipeline entwerfen, die den richtigen kontrollierten Input für das LLM erzeugt. Darüber hinaus musst Du die Nachbearbeitungsprozesse für die Antwort entwerfen. Schließlich solltest Du nicht vergessen, einen Prozess für Qualitätskontrollen und Sicherheitsmaßnahmen zu entwerfen und zu überlegen, wie das LLM verbessert werden kann.

LLM-Lösung für die geschäftliche Nutzung

3. LLM-Lösungsansatz

Zunächst musst Du bei Deinem LLM-Lösungsansatz entscheiden, inwieweit Du Dich auf verfügbare Lösungen stützen und wie viel Du selbst entwickeln willst. Das gilt für alle verschiedenen Komponenten der kompletten LLM-Lösung, d. h. das LLM selbst, Teile der LLM-Pipeline, externe vs. interne Datennutzung, die Qualitätssicherungsmaßnahmen und die Modellpflege. Danach musst Du Dich entscheiden, wo Du Dein LLM hosten willst. Möchtest Du Deine eigene Infrastruktur oder einen bestehenden Cloud-Anbieter nutzen (wenn ja, welchen)? Die richtige Mischung hängt von Deiner KI-Strategie, von den Kosten der verschiedenen Ansätze und von den Fähigkeiten sowie dem KI-Reifegrad Deines Unternehmens ab.

4. LLM-Auswahl: Welches LLM soll es werden?

Schließlich ist es an der Zeit, sich auf die Suche nach einem geeigneten LLM für Deine Aufgabe zu machen. Es gibt eine ganze Reihe verschiedener LLMs, und viele große und kleine Anbieter arbeiten eifrig an der Entwicklung neuer LLMs. Du kannst zwischen verschiedenen LLMs der wichtigsten Cloud-Plattform-Anbieter wie GCP, MS Azure oder AWS wählen. Alternativ kannst Du Open-Source-Alternativen in beliebten LLM-Repository-Sites wie Hugging Face (https://huggingface.co/) finden.

Bei der Auswahl des LLMs gilt es einige wichtige Aspekte zu berücksichtigen. Der erste ist die Art des LLMs. Wir unterscheiden zwischen grundlegenden LLMs und spezifischeren LLMs. Die grundlegenden LLMs sind Modelle, die für alle Arten von allgemeinen textbasierten generativen KI-Aufgaben entwickelt und trainiert wurden. Die spezifischen LLMs sind bereits auf bestimmte Bereiche oder Themen abgestimmt. Wenn Deine Aufgabe zu einem der speziellen Themen passt, dann ist es eine gute Idee, sich ein solches LLM zuerst anzuschauen. Ein weiterer wichtiger Aspekt, den es zu berücksichtigen gilt, ist die Größe des LLMs. Sie wird in der Anzahl der Parameter gemessen. Kleinere LLMs sind etwas ungenauer und nicht in allen Bereichen anwendbar, die Anwendung erfordert jedoch weniger Ressourcen und ist kostengünstiger. Im Allgemeinen solltest Du Dich für das kleinste LLM entscheiden, das für Deinen Anwendungsfall geeignet ist und die erforderliche Genauigkeit aufweist. Das spart Geld und Aufwand. Außerdem können viele bestehende LLMs mit Deinen eigenen Daten feinabgestimmt werden, so dass Du ein maßgeschneidertes LLM erstellen kannst, das genau Deinem Zweck entspricht.

Wie geht man jetzt weiter vor?

Deine allgemeine KI-Strategie und Dein Reifegrad werden den Ansatz bestimmen. Wenn KI ein wichtiger Transformationsaspekt Deines Unternehmens ist, musst Du wahrscheinlich voll einsteigen und interne KI-Fähigkeiten für LLMs aufbauen. Wenn Du Dich eher auf einem schrittweisen Weg der KI-Verbesserung befindest, kannst Du zwei bis drei wichtige LLM-Anwendungsfälle auswählen und einen PoC durchführen, um den Wert des Ansatzes zu demonstrieren und Dein KI-Engagement schrittweise auszubauen.

Wenn Du mehr über den strukturierten Ansatz von b.telligent zur Entwicklung Deines Unternehmens mit LLMs und generativer KI erfahren möchtest, kannst Du mich unter jukka.hekanaho@btelligent.com kontaktieren oder mich auf LinkedIn erreichen.

Hier geht's zu meinem LinkedIn-Profil!