Diese komplette und schrittweise schnelle Demo zeigt Ihnen, wie man eine existierende Datenquelle intern mit einer modernen Cloud-Warehouse-Lösung wie Snowflake verbindet:

- Einfach

- Schnell

- Sicher und

- ohne eine einzige Codezeile schreiben zu müssen.

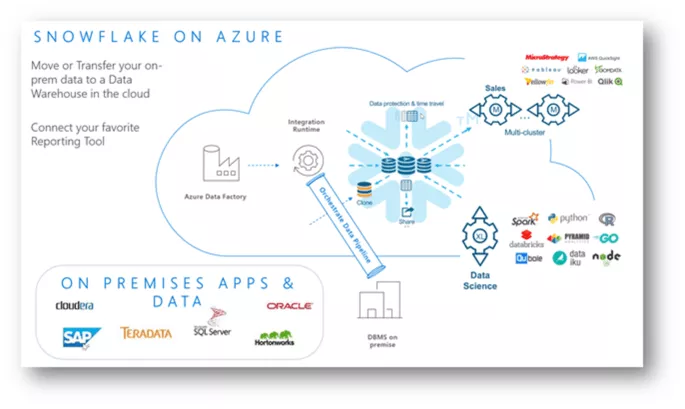

Außerdem zeigt die Demo, dass Snowflake in Azure eine großartige Kombination aus der Azure Datenfabrik, den Funktionen von Azure und Microsoft Power BI neben weiteren bekannten verbundenen Services im Azure-Cloud-Ökosystem ist, inklusive der Funktion des einmaligen Anmeldens im Azure Active-Adressbuch. Es wird außerdem aufgezeigt, dass es möglich ist, eine Hyperscale-Unternehmens-Datenanalytiklösung mit einer Zwei-Anbieter-Strategie zu bauen.

Die Azure Datenfabrik kann sowohl ELT und ETL Aufgaben erledigen. Momentan ist kein systemeigener Snowflake Open-Source-Anschluss in ADF V2 verfügbar. Allerdings sind mit dem Snowflake.net Driver verschiedene Optionen für Arbeitsbelastungen mit Azure-Funktionen und benutzerdefinierten Aktivitäten, zusammen mit Azure Datenfabrik-Pipelines, möglich.

Die Szenarien hängen von vielen Faktoren und Umständen ab. In unserem Fall sind die Quellen meistens relationale Datenbank-Management-Systeme. Aus verschiedenen Gründen wollen wir Daten nicht aus unserer Quelle in eine CSV-Datei ziehen und die CSV dann zur Cloud-Blob-Lagerung übertragen sowie diese in Snowflake mit systemeigenen Anschlüssen einspielen. Allerdings wäre dies immer noch ein sinnvolles und geläufiges Szenario.

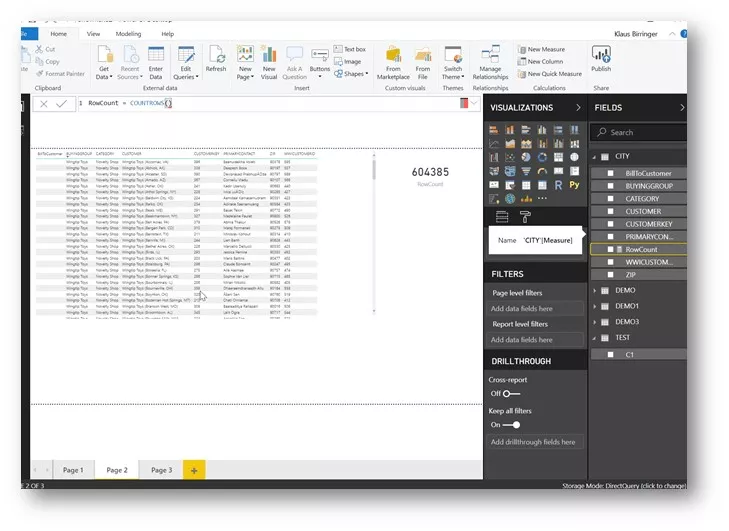

Wir wollen ein Szenario verwenden, in dem wir beide Datenbanken direkt verbinden können, indem wir mithilfe der Azure Datenfabrik die Daten direkt aus den Quellentabellen in Snowflake-Tabellen einspielen. Nach dem Einspielen der Daten möchten wir Microsoft Power BI dazu verwenden, die Daten mithilfe einer Live-Verbindung zu dem Analytik-Modell zu analysieren. Diese direkte Verbindung zum Datenlager hat den Vorteil, dass wir die Daten nicht wieder aus Snowflake laden müssen.

Instrumente und Services, die in der Demo verwendet werden:

- SQL Server 2017 Datenbank, intern

- Azure Runtime-Integration, intern

- Azure Datenfabrik V2 Pipeline (Runtime-Integration konfiguriert)

- Snowflake Datenlager

- Power BI

Hintergrund: Architektur bei Azure – wie wir es gebaut haben

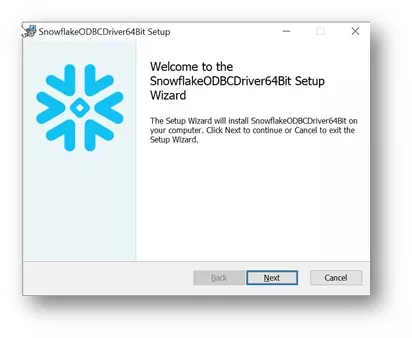

Installieren Sie den Snowflake ODBC Driver

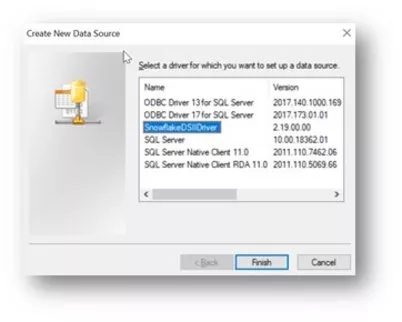

Öffnen Sie ODBC Datenquellen (64-Bit) und erstellen Sie eine neue Datenquelle

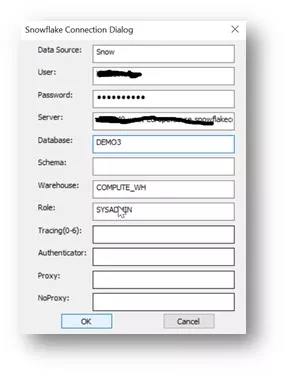

Geben Sie die Details in das Snowflake-Verbindungs-Dialogfenster ein

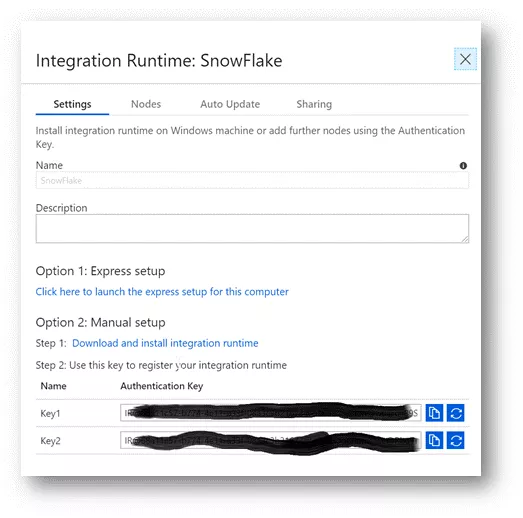

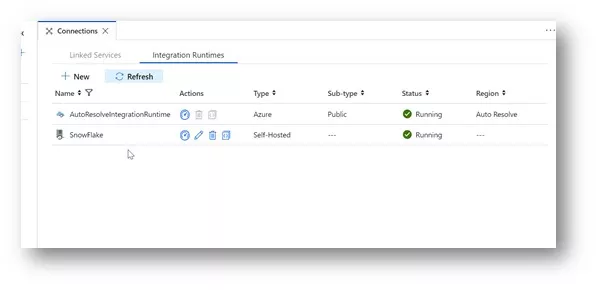

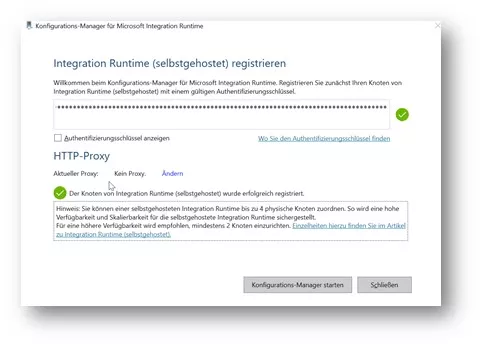

Installieren und konfigurieren Sie die Azure Runtime-Integration und erstellen bzw. konfigurieren Sie die Runtime-Integration in einer Azure Datenfabrik V2

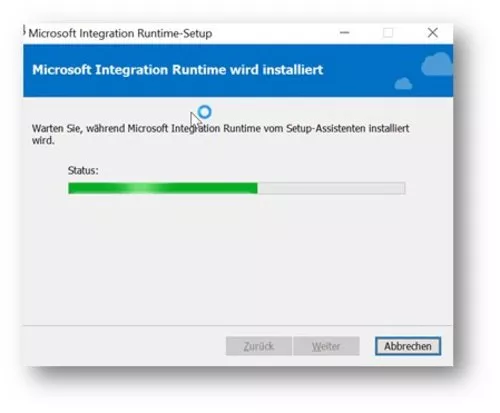

Installieren Sie Azure Runtime-Integration, intern (On-Premises)

Registrieren Sie die Laufzeit (Runtime) und geben Sie den Authentifizierungsschlüssel der ADF V2 Runtime ein, den Sie vorher erstellt haben

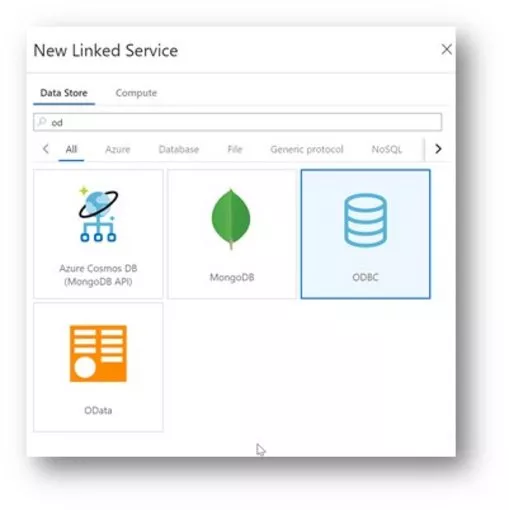

Erstellen Sie einen neuen ODBC-verknüpften Service in der Azure Datenfabrik

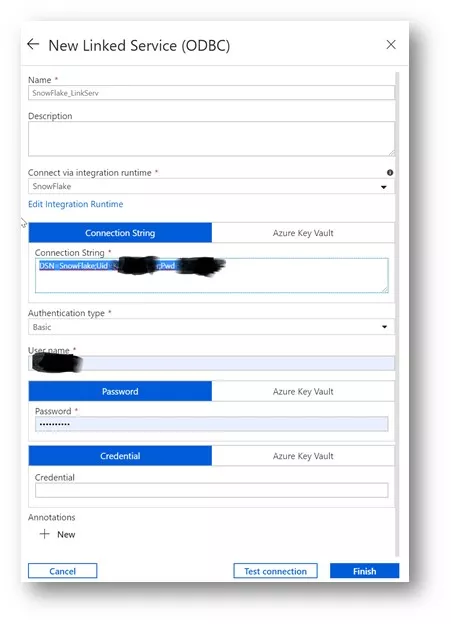

Konfigurieren Sie den ODBC-verknüpften Service, indem Sie den Namen der Datenquelle, den Benutzernamen und das vorher erstellte Passwort eingeben.

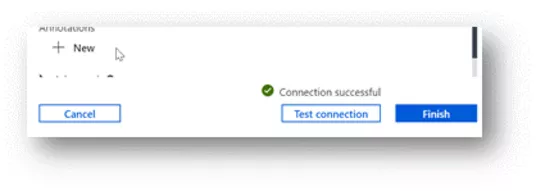

Testen Sie die Verbindung in der Azure Datenfabrik

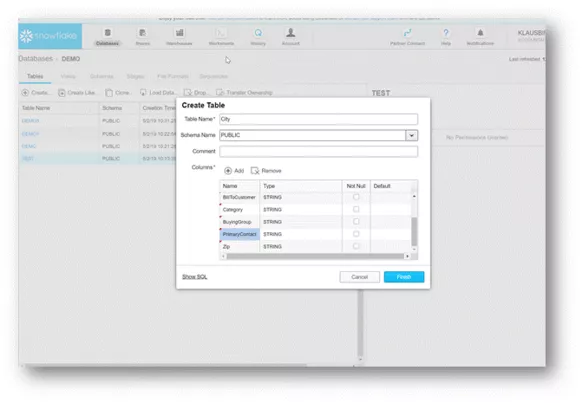

Erstellen Sie eine Tabelle in Snowflake - Datentypen sind in dieser schnellen Demo irrelevant.

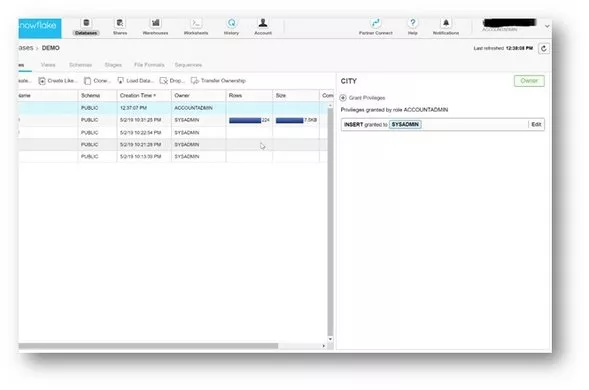

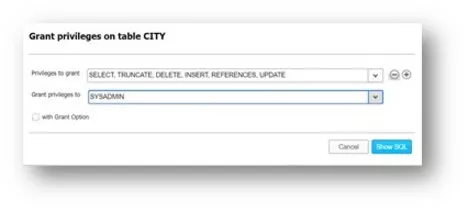

Erteilen Sie im Bedarfsfall entsprechende Zugriffsrechte. Für diese Demo wählen wir die Schnellversion, was normalerweise nicht empfohlen wird:

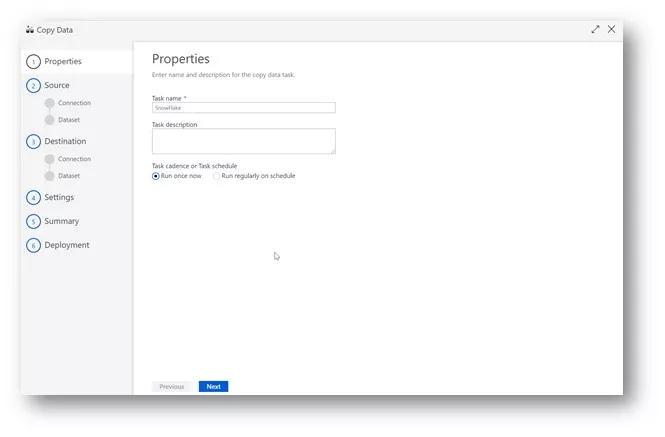

Kopieren Sie den Datenassistenten (Wizard) aus der Azure Datenfabrik V2

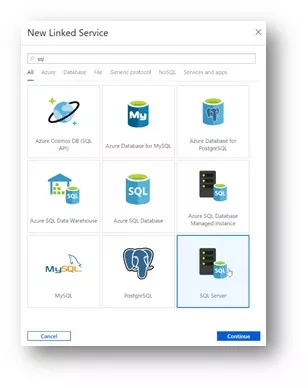

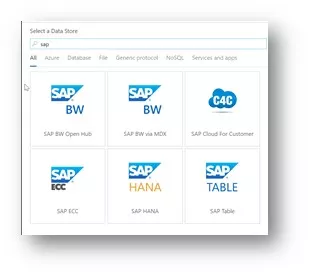

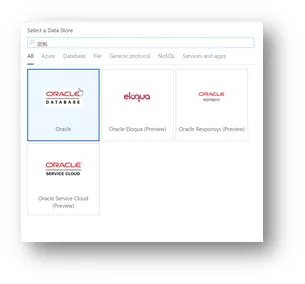

Erstellen Sie einen neuen verknüpften Service mit einem internen SQL-Server. Alle verknüfpten Services, die Azure Runtime-Integration unterstützen, sind hier verfügbar, inklusive Oracle, Sap, MySQL, Teradata, etc. Oder Sie können sich einfach mit einem „Direct Load“ durch die Azure Datenfabrik mit Snowflake verbinden.

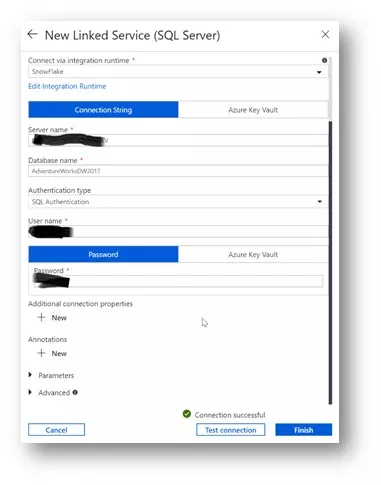

Geben Sie den Servernamen ein, den Sie durch die vorher konfigurierte Azure Runtime-Integration erhalten haben, und lassen Sie sich authentifizieren. Testen Sie die Verbindung.

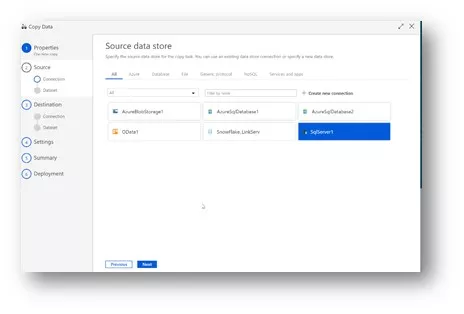

Wählen Sie nun die kürzlich konfigurierte interne Datenquelle aus.

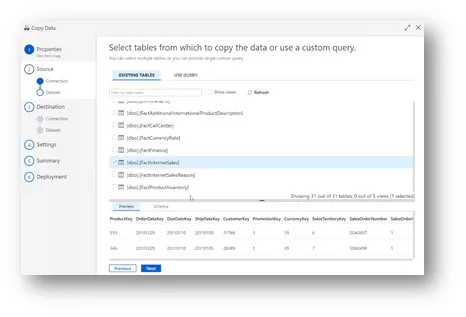

Wählen Sie Ihre Datentabellen aus Ihrer internen Datenquelle aus.

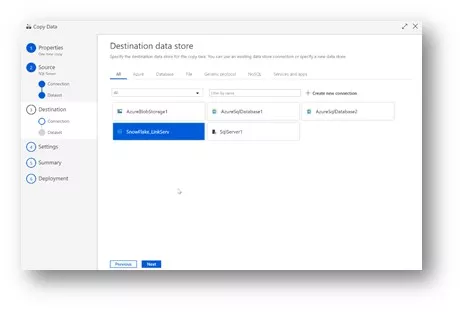

Wählen Sie den mit Snowflake verknüpften Service aus, der vorher als Bestimmungsort erstellt wurde

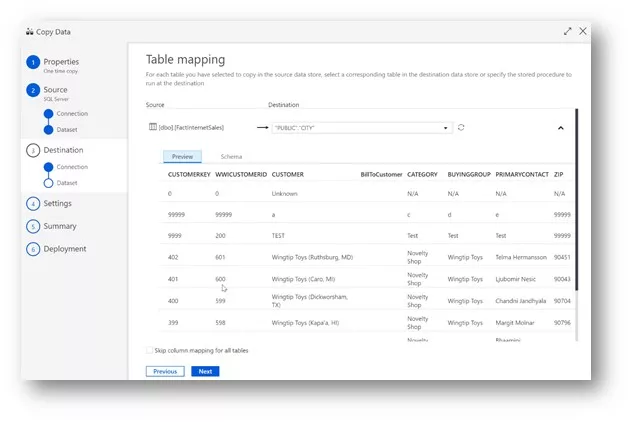

Ordnen Sie die ausgewählten Tabellen zu

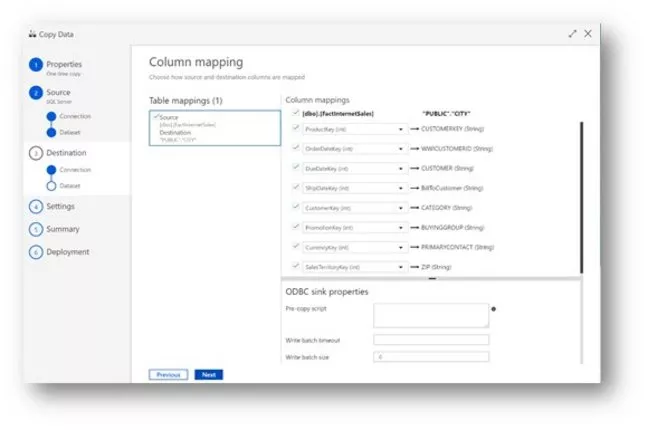

Ordnen Sie die Spalten den Tabellen zu

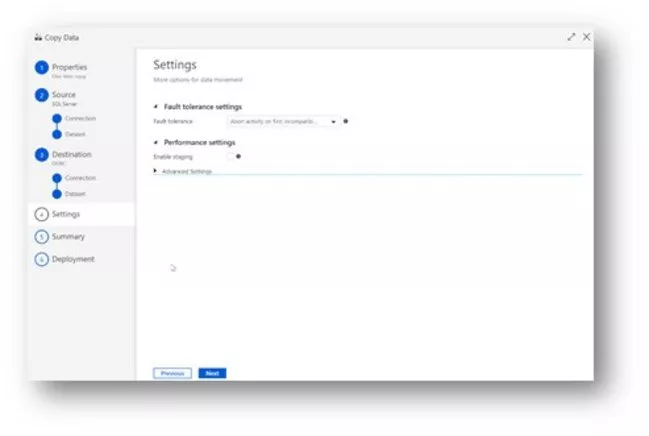

Einstellungen

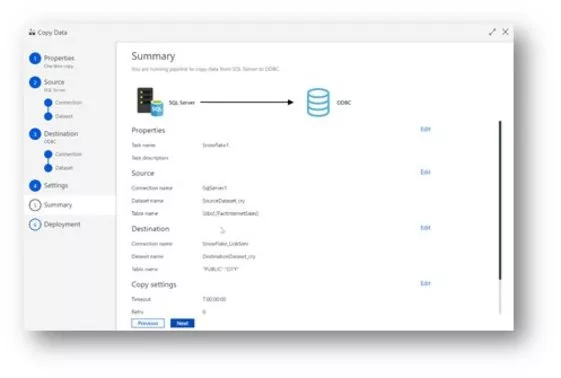

Zusammenfassung

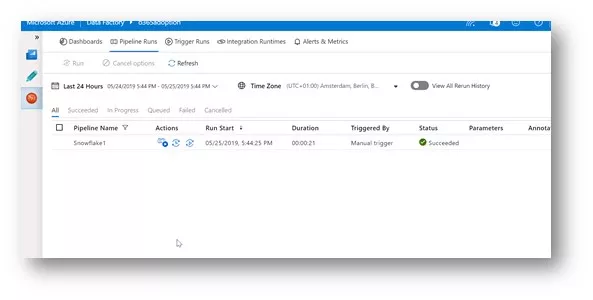

Lassen Sie die Pipeline laufen

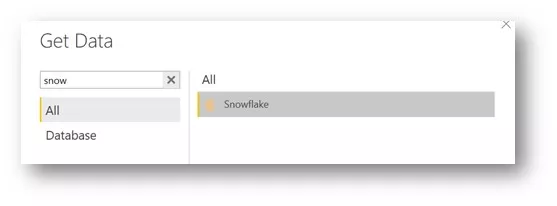

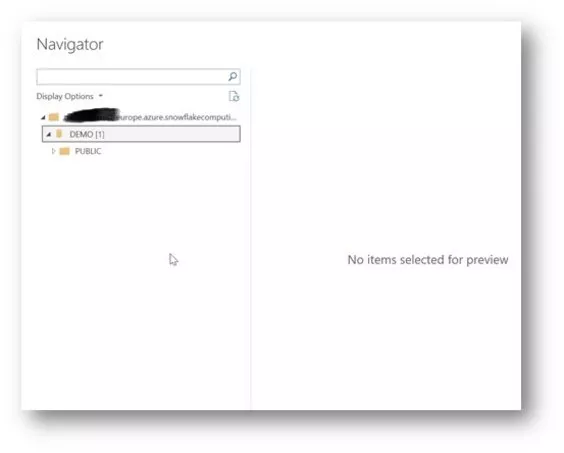

Verbinden Sie sich mit der Power BI Direct Query

Fazit

- Verbinden Sie sich schnell und einfach mit fast jeder internen Datenquelle – ohne dazu Codezeilen o.ä. schreiben zu müssen.

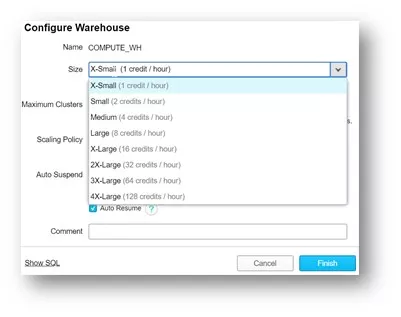

- Auch wenn es nicht so erscheint, hat die Lagergröße einen messbaren Einfluss auf ETL-/ELT-Arbeitsbelastungen/berichterstattende Arbeitsbelastungen. Dies bedeutet, dass das Konzept der Verwendung verschiedener Lagergrößen für verschiedene Arbeitsbelastungen von Nutzergruppen absolut Sinn macht.

- Momentan ist kein systemeigener Snowflake-Anschluss in ADF V2 verfügbar, aber es gibt einen .net-Driver, der dazu verwendet werden kann, um Ihren eigenen Anschluss zu erstellen.

- Die Demo zeigt, dass Snowflake in Azure eine großartige Kombination aus der Azure Datenfabrik, den Funktionen von Azure und Microsoft Power BI neben weiteren bekannten verbundenen Services im Azure-Cloud-Ökosystem ist, inklusive der Funktion des einmaligen Anmeldens im Azure Active-Adressbuch. Außerdem wird aufgezeigt, dass es möglich ist, eine Hyperscale-Unternehmens-Datenanalytiklösung mit einer Zwei-Anbieter-Strategie zu bauen.

- Die Übertragung größerer Datenvolumen kann länger dauern, abhängig von verschiedenen Faktoren.